Заметки о Праге (Чехия)

Был тут 5-13 июня. Это третья страна, после Венгрии и Турции

Жилье на этот раз нашли через эирбнб и жили втроем в небольшой, но вполне уютной квартирке.

Был тут 5-13 июня. Это третья страна, после Венгрии и Турции

Жилье на этот раз нашли через эирбнб и жили втроем в небольшой, но вполне уютной квартирке.

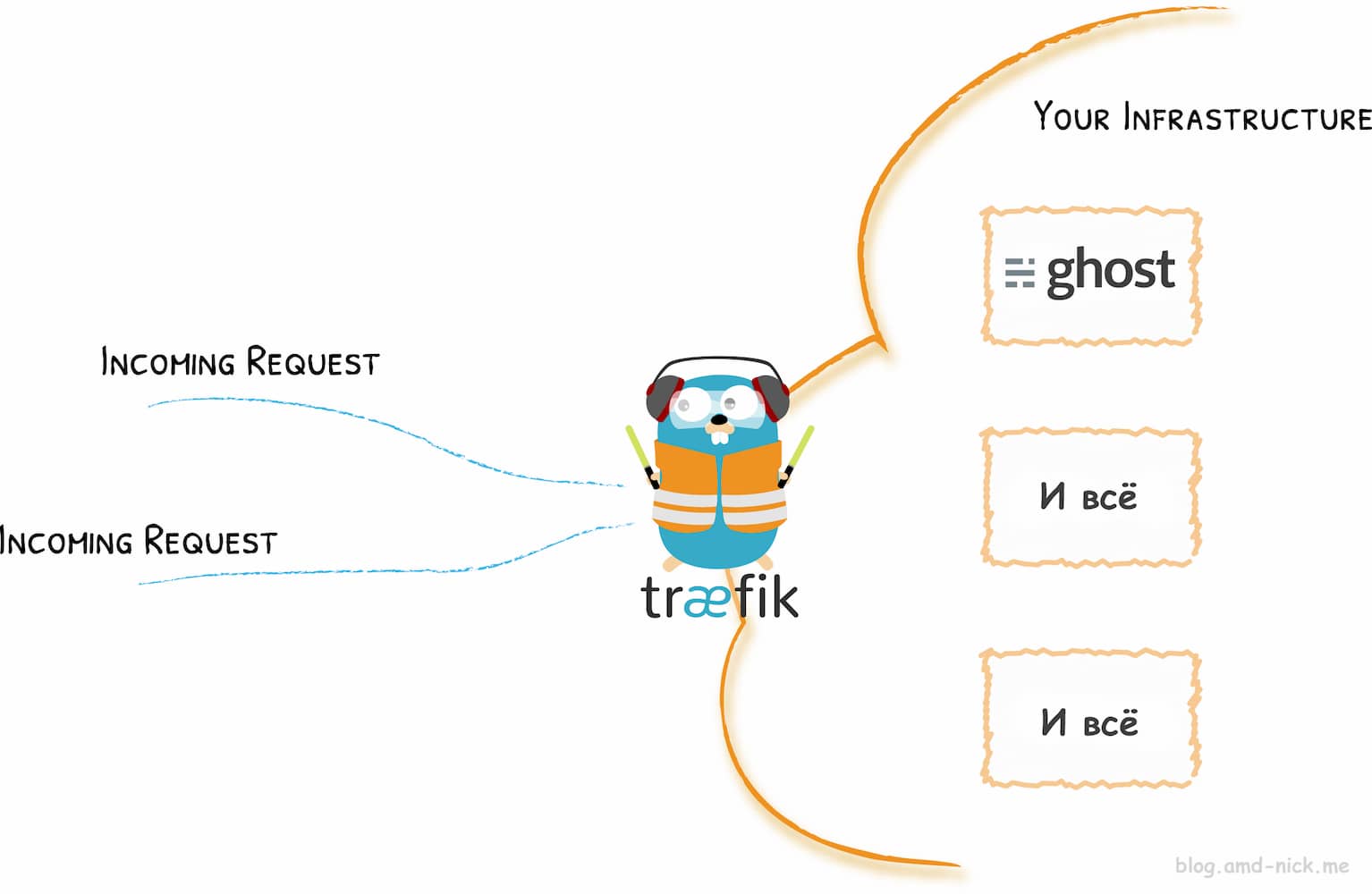

Этот блог работает внутри Docker контейнера и использует Traefik в качестве reverse proxy для Ghost. Недавно вышла версия v2.0, в которой были изменены некоторые фундаментальные особенности, что требует переконфигурации trafik.toml, acme.json и docker-compose.yml

У Traefik есть официальная инструкция по обновлению, и то ли я дурак, то ли ее стоит доработать, но факт в том, что после получаса вкуривания заново все настроить для меня было гораздо проще и полезнее

21 декабря 2018 года я рискнул полететь на месяц за границу с человеком, которого к тому времени видел раз в жизни) Как и с Будапештом, собрал несколько заметок

Учет расходов велся, потом пилился на двоих, но я его потерял. Помню только, что за месяц там потратили меньше, чем в Украине

Итак, вы уже знаете какой-то язык, нашли GitHub репозиторий с проектом на Golang и решили его поковырять. В основах, как тру проггер разберетесь методом тыка, нужно как-то только начать. Hello World для слабаков

Этот блог работает (на момент написания) внутри Docker контейнера. Привязка обеспечивает загрузку картинок в хранилище Amazon S3 вместо сохранения на локальном диске, поэтому контейнер остается stateless и ему плевать на перезагрузки и ребилды

За загрузку и получение картинок со сторонних сервисов в Ghost отвечают storage adapters. Я использую ghost-storage-adapter-s3 и это был мой первый опыт работы с AWS.

Это был первый раз, когда я оказался за границей. Как, наверное, и любого другого человека, у меня вызывали интерес особенности, которых не было в моей стране (Украине)

Это был октябрь 2018 года и летел я туда на неделю с другом через wizztours (нынче закрытый). Тогда они предлагали скидку 100$, если через них взять жилье + перелет. Вместе мы потратили около 12000 грн (30к руб на сегодня)

Coroutines (сопрограммы) позволяют разбивать громоздкие задачи на части, чтобы те не "вешали" процесс.

Привет из 2023. В свое время пост принес мне много вопросов от желающих использовать API, а еще наверняка немного внутреннего хейта от команды DMarket.

Мой путь с DMarket лежал с самого начала �его существования, с ICO, а закончился год назад баном. Поддержка не смогла внятно ответить на мои многичесленные вопросы о причинах бана, несмотря на то, что у нас перед баном были многочесленные диалоги обо всем и все были очень приветливы друг к другу (несмотря на этот пост злобы), а я всегда был благодарен за помощь.

Год назад, после начала войны, я очередной раз авторизировался на сайте, после чего получил табличку бана. Поддержка сказала пройти верификацию, скинуть им фотки и все дела. После чего объявила об окончательном, бесповоротном парманентном бане, который запрещено обжаловать и запрещено узнать официальную причину.

Сейчас не имеет смысла врать, если бы на это были действительно настоящие причины, например, какие-то махинации с моей стороны или злоупотребление их услугами, но причин для бана действительно не было и я уверен, что это даже не из-за этого поста.

Но раз я начал редактировать этот пост, то я решил все же донести мысль, что ваши вещи, по сути, ваши настоящие деньги, могут быть запросто заблокированы по прихоти каких-то людей без объяснения причин и возврата д�енег. Навсегда. Деньги самого обычного, рядового пользователя.

Заметки для тех, кто решил поработать с API DMarket.com. Сразу предупреждаю, что некоторые из них могут быть неуместны, поскольку все знать невозможно и я просто не понял разработчиков, что сделали ту или иную "странность"

Проблема динамического IP в том, что для работы сайта или веб приложения нужно следить за тем, чтобы домен всегда указывал на актуальный адрес, иначе сайт будет недоступен.

Я столкнулся с этой проблемой, когда настраивал доступ к Raspberry Pi по SSH.

Получить доступ к Raspbery Pi с любой точки мира через SSH. По этому же принципу кроме SSH можно достучаться до FTP, веб приложениям и сайтам, а также любым другим сервисам